Conţinut

- Datele mari sunt nestructurate sau semi-structurate

- Nu există niciun punct în stocarea datelor mari dacă nu le putem prelucra

- Cum rezolvă Hadoop problema Big Data

- Cazul de afaceri pentru Hadoop

La pachet:

Hadoop poate ajuta la rezolvarea unor mari provocări de date mari.

Datele mari sunt ... bine ... au dimensiuni mari! Exact cât de multe date pot fi clasificate ca date mari nu este foarte clar, astfel încât să nu ne împiedicăm în această dezbatere. Pentru o companie mică care este obișnuită să trateze datele din gigabytes, 10 TB de date ar fi BIG. Cu toate acestea, pentru companii precum și Yahoo, petabytes este mare.Doar dimensiunea datelor mari, face imposibilă (sau cel puțin costă prohibitivă) stocarea acesteia în stocarea tradițională, precum baze de date sau fișiere convenționale. Vorbim despre costul pentru stocarea gigabytes de date. Folosirea fișierelor tradiționale de stocare poate costa foarte mulți bani pentru a stoca date mari.

Aici ar trebui să aruncați o privire asupra datelor mari, provocărilor sale și a modului în care Hadoop vă poate ajuta să le rezolvați.În primul rând, date mari provocări majore.

Datele mari sunt nestructurate sau semi-structurate

O mulțime de date mari nu sunt structurate. De exemplu, faceți clic pe datele de jurnal de flux ar putea arata astfel:timbru de timp, user_id, pagina, pagina referrer_

Lipsa structurii face ca bazele de date relaționale să nu fie foarte potrivite pentru stocarea datelor mari. În plus, nu multe baze de date pot face față stocării a miliarde de rânduri de date.

Nu există niciun punct în stocarea datelor mari dacă nu le putem prelucra

Stocarea de date mari face parte din joc. Trebuie să-l procesăm pentru a-mi elimina inteligența. Sistemele tradiționale de stocare sunt destul de „mut” în sensul că stochează doar biți. Nu oferă nicio putere de procesare.Modelul tradițional de prelucrare a datelor conține date stocate într-un cluster de stocare, care este copiat într-un cluster de calcul pentru procesare. Rezultatele sunt redactate în clusterul de stocare.

Cu toate acestea, acest model nu funcționează destul de mult pentru date mari, deoarece copierea atât de multă date într-un cluster de calcul poate duce prea mult timp sau imposibil. Deci, care este răspunsul?

O soluție este să prelucrați date mari în loc, cum ar fi într-un cluster de stocare care se dublează ca un cluster de calcul.

Așa cum am văzut mai sus, datele mari definesc stocarea tradițională. Deci, cum gestionăm datele mari?

Cum rezolvă Hadoop problema Big Data

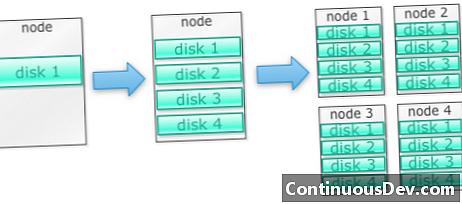

Hadoop este construit pentru a rula pe un grup de mașiniSă începem cu un exemplu. Permiteți să spunem că trebuie să stocăm o mulțime de fotografii. Vom începe cu un singur disc. Când depășim un singur disc, este posibil să folosim câteva discuri stivuite pe o mașină. Când maximizăm toate discurile pe o singură mașină, trebuie să obținem o grămadă de mașini, fiecare cu o grămadă de discuri.

Acesta este exact modul în care este construit Hadoop. Hadoop este proiectat pentru a rula pe un grup de mașini din start.

Clusterele Hadoop se scalează pe orizontală

Mai multă putere de stocare și calcul poate fi obținută adăugând mai multe noduri la un cluster Hadoop. Acest lucru elimină necesitatea de a cumpăra hardware din ce în ce mai puternic și mai scump.

Hadoop poate gestiona date nestructurate / semi-structurate

Hadoop nu aplică o schemă asupra datelor stocate. Poate gestiona date arbitrare și binare. Deci Hadoop poate digera ușor orice date nestructurate.

Clusterele Hadoop asigură stocarea și calcularea

Am văzut cum a avea grupuri de stocare și procesare separate nu este cea mai potrivită pentru datele mari. Cu toate acestea, grupurile de Hadoop asigură stocarea și calcularea distribuită toate în unul.

Cazul de afaceri pentru Hadoop

Hadoop oferă stocare pentru date mari, la costuri rezonabile

Stocarea de date mari folosind stocarea tradițională poate fi costisitoare. Hadoop este construit în jurul hardware-ului de marfă, astfel încât poate oferi o stocare destul de mare la un cost rezonabil. Hadoop a fost folosit în câmp la scara petabyte.

Un studiu realizat de Cloudera a sugerat că, de obicei, întreprinderile cheltuiesc în jur de 25.000 până la 50.000 dolari pe terabyte pe an. Cu Hadoop, acest cost scade la câteva mii de dolari pe terabyte pe an. Pe măsură ce hardware-ul devine mai ieftin și mai ieftin, acest cost continuă să scadă.

Hadoop permite captarea de date noi sau mai multe

Uneori organizațiile nu captează un tip de date, deoarece a fost prea prohibitiv să le stocheze. Deoarece Hadoop oferă stocare la costuri rezonabile, acest tip de date pot fi capturate și stocate.

Un exemplu ar fi jurnalele de clic pe site-ul web. Deoarece volumul acestor jurnale poate fi foarte mare, nu multe organizații au capturat acestea. Acum, cu Hadoop este posibilă captarea și stocarea jurnalelor.

Cu Hadoop, puteți stoca date mai mult

Pentru a gestiona volumul de date stocate, companiile purjează periodic date mai vechi. De exemplu, doar jurnalele din ultimele trei luni puteau fi stocate, în timp ce jurnalele mai vechi au fost șterse. Cu Hadoop este posibil să stocați datele istorice mai mult timp. Aceasta permite efectuarea de noi analize pe date istorice mai vechi.

De exemplu, luați jurnalele de clicuri de pe un site web. Cu câțiva ani în urmă, aceste jurnaluri au fost stocate pentru o scurtă perioadă de timp pentru a calcula statistici precum paginile populare. Acum, cu Hadoop, este viabil să stocați aceste jurnale de clic pe o perioadă mai lungă de timp.

Hadoop oferă analize scalabile

Nu are rost să stocăm toate aceste date dacă nu le putem analiza. Hadoop nu numai că furnizează stocare distribuită, ci și procesare distribuită, ceea ce înseamnă că putem paralela un volum mare de date în paralel. Cadrul de calcul al Hadoop se numește MapReduce. MapReduce a fost dovedit la scala de petabytes.

Hadoop oferă analize bogate

Native MapReduce acceptă Java ca limbaj de programare primar. Se pot folosi și alte limbi precum Ruby, Python și R.

Desigur, scrierea codului MapReduce personalizat nu este singura modalitate de a analiza datele din Hadoop. Este disponibilă Reducerea Hărții de nivel superior. De exemplu, un instrument numit Pig ia limba engleză ca limbajul fluxului de date și le traduce în MapReduce. Un alt instrument, Hive, ia interogări SQL și le execută folosind MapReduce.

Instrumentele de business intelligence (BI) pot oferi un nivel de analiză și mai ridicat. Există instrumente și pentru acest tip de analiză.

Acest conținut este extras din „Hadoop Illuminated” de Mark Kerzner și Sujee Maniyam. A fost pusă la dispoziție prin licență Creative Commons Atribuire-NonComercial-ShareAlike 3.0 Nemportată.